Analyse de la syntaxe dans les chants complexes de baleines

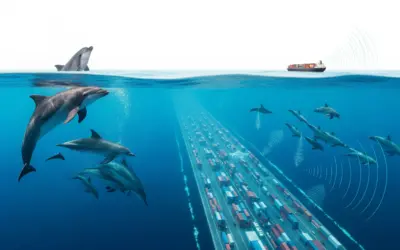

Contexte : Le langage des géants des mers.

Les chants des baleines à bosse sont parmi les vocalisations les plus complexes du règne animal. Loin d'être une simple suite de sons, ces chants possèdent une structure hiérarchique et grammaticale, avec des "notes" s'assemblant en "phrases", qui elles-mêmes forment des "thèmes" répétés. La bioacoustiqueScience qui étudie la production, la transmission et la réception des sons par les êtres vivants, ainsi que leurs rôles écologiques et évolutifs. utilise des outils issus de la linguistique et de la théorie de l'information pour déchiffrer cette syntaxeEnsemble des règles qui régissent la manière dont les unités (mots, sons) peuvent être combinées pour former des séquences plus longues (phrases, chants).. Cet exercice propose d'appliquer ces outils pour quantifier la complexité et la structure d'un chant de baleine simplifié, afin de comprendre comment les scientifiques mesurent l'information contenue dans ces communications acoustiques.

Remarque Pédagogique : Cet exercice est une porte d'entrée vers la biologie computationnelle et l'analyse de signaux. Nous allons utiliser un concept mathématique puissant, l'entropie de ShannonMesure mathématique de l'incertitude ou de la quantité d'information. Une entropie élevée signifie une grande imprévisibilité (beaucoup d'information), tandis qu'une entropie faible signifie une grande prévisibilité (peu d'information)., pour mettre un chiffre sur la "complexité" d'un chant. C'est une démarche qui dépasse la simple observation pour entrer dans la modélisation quantitative du comportement animal, une compétence clé en recherche moderne.

Objectifs Pédagogiques

- Calculer la probabilité d'occurrence de différentes unités sonores.

- Appliquer la formule de l'entropie de Shannon pour quantifier la complexité d'un répertoire vocal.

- Analyser une matrice de transitionTableau qui montre la probabilité de passer d'un état (ou d'une note) à un autre. C'est le cœur d'un modèle de chaîne de Markov, qui décrit les règles de la syntaxe. pour identifier les "règles grammaticales" du chant.

- Calculer et comparer le débit d'informationQuantité d'information (en bits) transmise par unité de temps (par seconde). Il combine la complexité (entropie) et la vitesse de communication (durée). de différentes séquences vocales.

- Comprendre comment les outils mathématiques peuvent être utilisés pour étudier la communication animale.

Données de l'étude

Structure simplifiée d'une phrase de chant

| Note | Durée Moyenne | Probabilité d'Occurrence (p) |

|---|---|---|

| A | 1.5 s | 0.50 |

| B | 2.0 s | 0.25 |

| C | 3.0 s | 0.15 |

| D | 1.0 s | 0.10 |

| De \ À | A | B | C | D |

|---|---|---|---|---|

| A | 0.1 | 0.8 | 0.1 | 0.0 |

| B | 0.0 | 0.5 | 0.5 | 0.0 |

| C | 0.9 | 0.0 | 0.0 | 0.1 |

| D | 1.0 | 0.0 | 0.0 | 0.0 |

Questions à traiter

- Calculer l'entropie de Shannon (H) du répertoire de notes. Que représente cette valeur ?

- En utilisant la matrice de transition, quelle est la "phrase" de 3 notes la plus probable commençant par la note A ?

- Calculer la durée totale de cette phrase de 3 notes la plus probable (en incluant les silences).

- Calculer le débit d'information (en bits/s) pour la phrase "A-B-C".

Les bases de l'Analyse Syntaxique

Avant la correction, revoyons les concepts mathématiques que nous allons utiliser.

1. L'Entropie de Shannon (H) :

En théorie de l'information, l'entropie mesure l'incertitude ou l'imprévisibilité d'un ensemble d'événements (ici, les notes). Si toutes les notes sont équiprobables, l'incertitude est maximale. Si une note est très fréquente, l'incertitude est faible. Elle se calcule en bits avec la formule :

\[ H = - \sum_{i=1}^{n} p_i \log_2(p_i) \]

où \(p_i\) est la probabilité de la note \(i\).

2. Chaînes de Markov et Syntaxe :

On peut modéliser la syntaxe d'un chant comme une chaîne de Markov, où la probabilité de la prochaine note ne dépend que de la note actuelle. La matrice de transition contient toutes ces probabilités conditionnelles. La probabilité d'une séquence de notes (une phrase) est simplement le produit des probabilités de chaque transition successive.

3. Débit d'Information :

Le débit d'information (ou taux d'information) mesure l'efficacité de la communication. Il ne suffit pas d'avoir un message complexe (haute entropie), il faut aussi le transmettre rapidement. Le débit combine ces deux aspects :

\[ \text{Débit} = \frac{\text{Information (en bits)}}{\text{Temps (en secondes)}} \]

L'information d'une séquence est la somme des informations de chaque note, où l'information d'une note \(i\) est \(-\log_2(p_i)\).

Correction : Analyse de la syntaxe dans les chants complexes de baleines

Question 1 : Calculer l'entropie de Shannon (H) du répertoire de notes

Principe (le concept physique)

L'entropie de Shannon est une mesure mathématique de l'incertitude ou de la quantité d'information moyenne. Dans le contexte du chant des baleines, elle quantifie l'imprévisibilité du choix de la prochaine note. Une entropie élevée signifie que les notes sont utilisées de manière équilibrée et qu'il est difficile de prédire la suivante, ce qui suggère un répertoire potentiellement riche. Une entropie faible indique que quelques notes dominent, rendant le chant plus prévisible et répétitif.

Mini-Cours (approfondissement théorique)

Le concept a été introduit par Claude Shannon en 1948, fondant la théorie de l'information. Le logarithme en base 2 est utilisé car l'unité fondamentale de l'information est le bit, qui représente un choix entre deux options équiprobables. L'entropie \(H\) est donc le nombre moyen de bits nécessaires pour coder une note du répertoire.

Remarque Pédagogique (le conseil du professeur)

Imaginez deux alphabets. Le premier n'a que la lettre "A". Son entropie est nulle : aucune incertitude, le prochain caractère sera toujours un "A". Le second a les lettres "A", "B", "C", "D" avec des probabilités égales. Son entropie est maximale (pour 4 symboles) car il y a une incertitude maximale sur la prochaine lettre. Notre chant de baleine se situe entre ces deux extrêmes.

Normes (la référence réglementaire)

L'entropie de Shannon est un outil standard en traitement du signal, en compression de données (comme les formats .zip ou .jpeg) et en linguistique computationnelle. Son calcul est une étape fondamentale dans l'analyse de la complexité de n'importe quelle séquence de symboles, qu'il s'agisse de texte humain ou de communication animale.

Formule(s) (l'outil mathématique)

L'entropie de Shannon H est définie par :

Hypothèses (le cadre du calcul)

On suppose que les probabilités d'occurrence des notes fournies sont stationnaires (elles ne changent pas au cours du temps) et qu'elles sont statistiquement indépendantes pour ce premier calcul (on ne regarde pas encore les enchaînements).

Donnée(s) (les chiffres d'entrée)

- \(p_A = 0.50\)

- \(p_B = 0.25\)

- \(p_C = 0.15\)

- \(p_D = 0.10\)

Astuces(Pour aller plus vite)

La plupart des calculatrices n'ont pas de fonction \(\log_2\). Utilisez la formule de changement de base : \(\log_2(x) = \frac{\ln(x)}{\ln(2)}\) ou \(\log_2(x) = \frac{\log_{10}(x)}{\log_{10}(2)}\). La valeur de \(\ln(2)\) est environ 0.693.

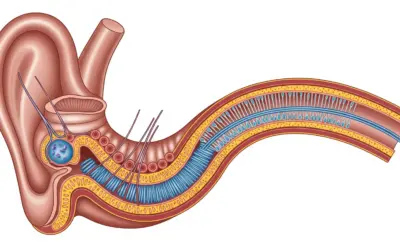

Schéma (Avant les calculs)

Distribution des probabilités des notes

Calcul(s) (l'application numérique)

On calcule le terme \( -p_i \log_2(p_i) \) pour chaque note :

On somme les termes pour obtenir l'entropie H :

Schéma (Après les calculs)

Distribution des probabilités et Entropie

Réflexions (l'interprétation du résultat)

L'entropie est de 1.743 bits/note. L'entropie maximale pour 4 symboles serait de \(\log_2(4) = 2\) bits (si p=0.25 pour tous). La valeur obtenue est assez proche du maximum, ce qui indique que même si la note A est plus fréquente, les autres notes apparaissent assez régulièrement pour maintenir un bon niveau de complexité et d'imprévisibilité dans le chant.

Points de vigilance (les erreurs à éviter)

Une erreur fréquente est d'oublier le signe négatif dans la formule. Comme les probabilités sont inférieures à 1, leur logarithme est négatif. Le signe "moins" initial assure que le résultat final est bien positif. Une entropie ne peut pas être négative.

Points à retenir (permettre a l'apprenant de maitriser la question)

- L'entropie (H) mesure l'incertitude ou la complexité d'un système.

- Elle est calculée en bits à partir des probabilités des événements.

- Une entropie élevée signifie une grande imprévisibilité.

Le saviez-vous ? (la culture de l'ingénieur)

La langue anglaise a une entropie d'environ 1.0 à 1.5 bits par lettre, bien inférieure au maximum théorique de \(\log_2(26) \approx 4.7\) bits. Cela est dû à la redondance de la langue (par exemple, un "q" est presque toujours suivi d'un "u"). Cette redondance nous permet de comprendre des mots même s'il manque des lettres.

FAQ (pour lever les doutes)

Résultat Final (la conclusion chiffrée)

A vous de jouer(pour verifier la comprehension de l'etudiant parrapport a la question)

Si les 4 notes étaient parfaitement équiprobables (p=0.25 pour toutes), quelle serait l'entropie en bits/note ?

Question 2 : Quelle est la phrase de 3 notes la plus probable commençant par A ?

Principe (le concept physique)

Cette question nous fait passer de l'analyse des notes individuelles à l'analyse de la syntaxe, c'est-à-dire les règles qui régissent leur enchaînement. La matrice de transition est une "carte" de ces règles. En la suivant, nous pouvons trouver le chemin le plus probable, ce qui correspond à la "phrase" la plus commune ou la plus stéréotypée dans le chant de la baleine.

Mini-Cours (approfondissement théorique)

Nous utilisons un modèle de chaîne de Markov du premier ordre. "Premier ordre" signifie que la probabilité de la prochaine note ne dépend que de la note immédiatement précédente. La probabilité d'une séquence entière (une phrase) est le produit de la probabilité de la note de départ et des probabilités de chaque transition successive.

Remarque Pédagogique (le conseil du professeur)

C'est exactement comme la fonction de suggestion de mots sur votre téléphone. En se basant sur le mot que vous venez de taper, elle prédit le mot suivant le plus probable. La matrice de transition est le "cerveau" de ce système de suggestion, contenant les probabilités apprises à partir de millions de textes.

Normes (la référence réglementaire)

Les chaînes de Markov sont un outil fondamental en modélisation stochastique, avec des applications allant de la finance (modélisation des cours de la bourse) à la bio-informatique (analyse de séquences d'ADN) et au traitement du langage naturel. Leur analyse est un domaine standard des statistiques et de l'apprentissage automatique.

Formule(s) (l'outil mathématique)

La probabilité d'une séquence de notes \(N_1, N_2, ..., N_k\) est donnée par :

Où \(P(N_{i+1}|N_i)\) est la probabilité de transition de la note \(N_i\) à la note \(N_{i+1}\), lue dans la matrice.

Hypothèses (le cadre du calcul)

On applique l'hypothèse de Markov du premier ordre : le choix de la prochaine note ne dépend que de la note actuelle et non des notes qui la précédaient.

Donnée(s) (les chiffres d'entrée)

On utilise la matrice de transition et le fait que la phrase commence par la note A.

Astuces(Pour aller plus vite)

Pour trouver la phrase la plus probable, on peut utiliser une approche "gloutonne" : à chaque étape, on choisit la transition qui a la plus grande probabilité. On part de A, on regarde la ligne "A" de la matrice et on choisit la colonne avec la plus grande valeur. Puis, on se place sur la ligne de cette nouvelle note et on recommence.

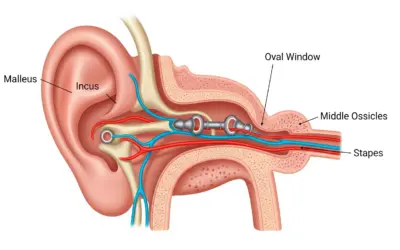

Schéma (Avant les calculs)

Recherche du chemin le plus probable

Calcul(s) (l'application numérique)

1. Première transition (de A à ?) : On regarde la ligne "A" de la matrice. La plus grande probabilité est 0.8, correspondant à la transition vers la note B. La première note après A est donc B.

2. Deuxième transition (de B à ?) : On regarde la ligne "B". Les probabilités vers B et C sont égales (0.5). Il y a donc deux phrases de 3 notes les plus probables. Choisissons la transition vers B. La deuxième note après A est B.

La séquence la plus probable (une d'entre elles) est donc A-B-B.

Calculons la probabilité de cette séquence :

L'autre phrase également la plus probable est A-B-C, avec la même probabilité de 0.20.

Schéma (Après les calculs)

Le chemin le plus probable trouvé

Réflexions (l'interprétation du résultat)

La phrase la plus probable est A-B-B (ou A-B-C). Cela révèle une structure grammaticale simple : après une note "A", il est très probable d'entendre une note "B". Après une note "B", il y a une chance égale d'entendre une autre note "B" ou une note "C". C'est le début du déchiffrage de la "langue" de la baleine.

Points de vigilance (les erreurs à éviter)

Il ne faut pas confondre la probabilité d'occurrence d'une note (première table) et la probabilité de transition (deuxième table). La première vous dit "quelle est la note la plus fréquente en général ?", la seconde vous dit "sachant que je viens d'entendre X, quelle est la note suivante la plus probable ?".

Points à retenir (permettre a l'apprenant de maitriser la question)

- La matrice de transition décrit les règles syntaxiques d'une séquence.

- La probabilité d'une phrase est le produit des probabilités de ses transitions.

- L'analyse de ces probabilités permet de trouver les motifs les plus courants.

Le saviez-vous ? (la culture de l'ingénieur)

Le célèbre algorithme PageRank de Google, qui classait les pages web, était basé sur un modèle de chaîne de Markov géant. Il modélisait un "surfeur aléatoire" naviguant sur le web et calculait la probabilité qu'il se trouve sur une page donnée. Les pages avec la plus haute probabilité étaient considérées comme les plus importantes.

FAQ (pour lever les doutes)

Résultat Final (la conclusion chiffrée)

A vous de jouer(pour verifier la comprehension de l'etudiant parrapport a la question)

Quelle est la seule note possible après une note D ?

Question 3 : Calculer la durée totale de la phrase A-B-B

Principe (le concept physique)

Cette question porte sur la dimension temporelle du chant. La durée d'une phrase n'est pas seulement la somme de la durée des notes qui la composent, mais doit aussi inclure les silences entre les notes. Ce rythme est un élément crucial de la communication, tout comme en musique ou dans la parole humaine.

Mini-Cours (approfondissement théorique)

L'analyse du rythme et du tempo (la structure temporelle) est un domaine important de la bioacoustique. Les variations de durée des notes et des silences peuvent coder différentes informations, comme l'identité de l'individu, son état émotionnel ou le contexte de la communication (par exemple, un chant de cour vs un signal d'alarme).

Remarque Pédagogique (le conseil du professeur)

Pensez à la phrase "Je t'aime". Dite rapidement, elle a un certain sens. Dite lentement, en marquant une pause entre chaque mot ("Je... t'aime..."), le sens et l'impact émotionnel sont complètement différents. La durée et les silences sont aussi importants que les mots (ou les notes) eux-mêmes.

Normes (la référence réglementaire)

En phonétique et en traitement de la parole, l'analyse de la prosodie (rythme, accentuation, intonation) est standardisée. Des mesures comme la durée des phonèmes et des pauses sont utilisées pour la reconnaissance vocale, la synthèse vocale et l'analyse des émotions dans la voix.

Formule(s) (l'outil mathématique)

La durée totale d'une phrase de \(k\) notes est :

Hypothèses (le cadre du calcul)

On utilise les durées moyennes pour les notes et les silences, en supposant qu'elles sont constantes pour ce calcul.

Donnée(s) (les chiffres d'entrée)

- Séquence : A-B-B

- \(T_A = 1.5 \, \text{s}\)

- \(T_B = 2.0 \, \text{s}\)

- \(T_{\text{silence}} = 0.5 \, \text{s}\)

Astuces(Pour aller plus vite)

N'oubliez pas qu'une phrase de 3 notes n'a que 2 silences interstitiels. De manière générale, pour \(k\) notes, il y a \(k-1\) silences.

Schéma (Avant les calculs)

Décomposition temporelle de la phrase A-B-B

Calcul(s) (l'application numérique)

On additionne les durées des notes et des deux silences :

Schéma (Après les calculs)

Durée totale de la phrase

Réflexions (l'interprétation du résultat)

La phrase la plus commune dure 6.5 secondes. Cette information est utile pour planifier la durée des enregistrements ou pour concevoir des algorithmes de reconnaissance automatique de chants, qui doivent savoir à quelle échelle de temps chercher des motifs récurrents.

Points de vigilance (les erreurs à éviter)

L'erreur la plus simple est de mal compter le nombre de silences. Il y a toujours un silence de moins que le nombre de notes dans une séquence. Oublier les silences conduirait à sous-estimer significativement la durée totale.

Points à retenir (permettre a l'apprenant de maitriser la question)

- La durée d'une phrase inclut les notes et les silences.

- Pour \(k\) notes, il y a \(k-1\) silences.

- Le rythme est une composante essentielle de la communication acoustique.

Le saviez-vous ? (la culture de l'ingénieur)

Le code Morse est un excellent exemple de communication où la durée est critique. Il utilise des signaux courts (points) et longs (traits), mais la durée des silences est également standardisée : un silence court entre les lettres, un silence plus long entre les mots. Une mauvaise gestion de ces durées rend le message inintelligible.

FAQ (pour lever les doutes)

Résultat Final (la conclusion chiffrée)

A vous de jouer(pour verifier la comprehension de l'etudiant parrapport a la question)

Quelle serait la durée de la phrase "D-A-C" en secondes ?

Question 4 : Calculer le débit d'information pour la phrase "A-B-C"

Principe (le concept physique)

Le débit d'information combine la complexité (l'imprévisibilité) d'un message avec sa durée. Il répond à la question : "À quelle vitesse cette baleine transmet-elle de l'information ?". Une phrase peut être très complexe (contenir des notes rares), mais si elle est très longue, son débit d'information peut être faible. Inversement, une phrase simple mais très rapide peut avoir un débit élevé. C'est une mesure de l'efficacité de la communication.

Mini-Cours (approfondissement théorique)

L'information d'un événement (ou d'une note) \(i\) est définie par Shannon comme \(I_i = -\log_2(p_i)\). C'est une mesure de la "surprise" : un événement rare (faible \(p_i\)) contient beaucoup d'information, tandis qu'un événement fréquent (haute \(p_i\)) en contient peu. L'entropie H que nous avons calculée à la question 1 est simplement l'espérance mathématique (la moyenne) de cette information sur toutes les notes.

Remarque Pédagogique (le conseil du professeur)

Comparer le débit d'information, c'est comme comparer deux personnes qui vous racontent une histoire. L'une parle très vite mais dit des banalités (haut débit, faible information par mot). L'autre parle lentement mais chaque mot est pesé et plein de sens (faible débit, haute information par mot). Le débit d'information en bits/s est la mesure qui permet de comparer objectivement leur efficacité globale à transmettre de la nouveauté.

Normes (la référence réglementaire)

Le concept de débit binaire (bitrate) est fondamental dans toutes les télécommunications modernes. La vitesse de votre connexion Internet est mesurée en Mégabits par seconde (Mbps). Les normes (comme celles pour la 4G, la 5G, le Wi-Fi) visent à maximiser ce débit tout en minimisant les erreurs, en utilisant des techniques de codage et de compression complexes.

Formule(s) (l'outil mathématique)

1. Information totale d'une séquence :

2. Débit d'information :

Hypothèses (le cadre du calcul)

On utilise l'information de chaque note basée sur sa probabilité d'occurrence globale (calcul de la Q1), sans tenir compte du contexte syntaxique, pour simplifier. Un calcul plus avancé utiliserait l'information conditionnelle des transitions.

Donnée(s) (les chiffres d'entrée)

- Séquence : A-B-C

- Informations des notes (partie du calcul de Q1) : \(I_A = 1 \text{ bit}\), \(I_B = 2 \text{ bits}\), \(I_C \approx 2.737 \text{ bits}\)

- Durées des notes : \(T_A = 1.5\text{s}, T_B = 2.0\text{s}, T_C = 3.0\text{s}\)

- \(T_{\text{silence}} = 0.5 \, \text{s}\)

Astuces(Pour aller plus vite)

Vous avez déjà calculé les termes \(-\log_2(p_i)\) pour trouver l'entropie à la question 1. Il suffit de les réutiliser ici. L'information d'une note est simplement le terme correspondant avant de le multiplier par sa probabilité.

Schéma (Avant les calculs)

Calcul du Débit d'Information

Calcul(s) (l'application numérique)

1. Calculer l'information totale de la phrase "A-B-C" :

2. Calculer la durée totale de la phrase "A-B-C" :

3. Calculer le débit d'information :

Schéma (Après les calculs)

Résultat du Débit d'Information

Réflexions (l'interprétation du résultat)

La phrase "A-B-C" transmet de l'information à un rythme d'environ 0.765 bits par seconde. Cette valeur peut sembler faible comparée à nos technologies, mais elle est significative pour une communication animale. En comparant ce débit à celui d'autres phrases, les biologistes peuvent déterminer quelles séquences sont les plus efficaces pour transmettre de l'information rapidement, ce qui peut être crucial lors d'interactions sociales rapides.

Points de vigilance (les erreurs à éviter)

Ne confondez pas l'information totale d'une phrase (en bits) et le débit d'information (en bits/s). Une phrase très longue peut contenir beaucoup d'information mais avoir un faible débit. Il est également crucial d'utiliser la bonne durée, en incluant bien les silences.

Points à retenir (permettre a l'apprenant de maitriser la question)

- Le débit d'information mesure l'efficacité de la communication (bits/s).

- Il dépend de la complexité (information) et de la durée de la séquence.

- Les notes rares apportent plus d'information mais peuvent allonger la durée.

Le saviez-vous ? (la culture de l'ingénieur)

Le premier modem pour ordinateur, en 1962, avait un débit de 300 bits/s. Le débit que nous avons calculé pour la baleine est donc du même ordre de grandeur que les débuts de notre propre communication numérique à distance !

FAQ (pour lever les doutes)

Résultat Final (la conclusion chiffrée)

A vous de jouer(pour verifier la comprehension de l'etudiant parrapport a la question)

Quel est le débit d'information (en bits/s) de la phrase plus simple "A-A" ?

Outil Interactif : Paramètres de Syntaxe

Modifiez les probabilités des notes pour voir leur influence sur la complexité (entropie) du chant.

Paramètres d'Entrée

P(B) = 0.25

P(C) = 0.15

P(D) = 0.10

Résultats Clés

Le Saviez-Vous ?

Les chants des baleines à bosse sont si structurés qu'ils respectent certaines lois linguistiques observées dans les langages humains, comme la loi de Zipf (qui stipule que la fréquence d'un mot est inversement proportionnelle à son rang dans le tableau des fréquences). Cela suggère que des principes d'organisation et d'efficacité similaires pourraient être à l'œuvre dans des systèmes de communication très différents.

Foire Aux Questions (FAQ)

Est-ce que toutes les baleines d'une même espèce chantent la même chose ?

Non. Les populations de baleines à bosse de différentes régions (par exemple, Pacifique Nord vs Atlantique Nord) ont des chants complètement différents. De plus, au sein d'une même population, le chant évolue d'année en année. C'est un exemple fascinant de transmission culturelle chez un animal non-humain.

Que signifie réellement un "bit" d'information dans ce contexte ?

Un bit est la quantité d'information nécessaire pour répondre à une question binaire (oui/non). Si un répertoire a une entropie de 1.74 bits, cela signifie qu'en moyenne, il faut 1.74 questions binaires pour deviner quelle sera la prochaine note. C'est une façon de quantifier l'imprévisibilité.

Quiz Final : Testez vos connaissances

1. Un chant très répétitif, utilisant presque toujours la même note, aura une entropie...

2. Dans une matrice de transition, une ligne qui ne contient qu'un "1.0" et des "0.0" signifie que...

- Entropie de Shannon

- Mesure de l'incertitude ou de la quantité d'information moyenne d'une source de données. Exprimée en bits, elle quantifie l'imprévisibilité.

- Syntaxe

- Ensemble de règles qui déterminent comment les éléments (comme les notes d'un chant) peuvent être combinés pour former des séquences valides et significatives.

- Chaîne de Markov

- Modèle mathématique décrivant une séquence d'événements où la probabilité de chaque événement ne dépend que de l'état de l'événement précédent.

D’autres exercices de Bioacoustique:

0 commentaires